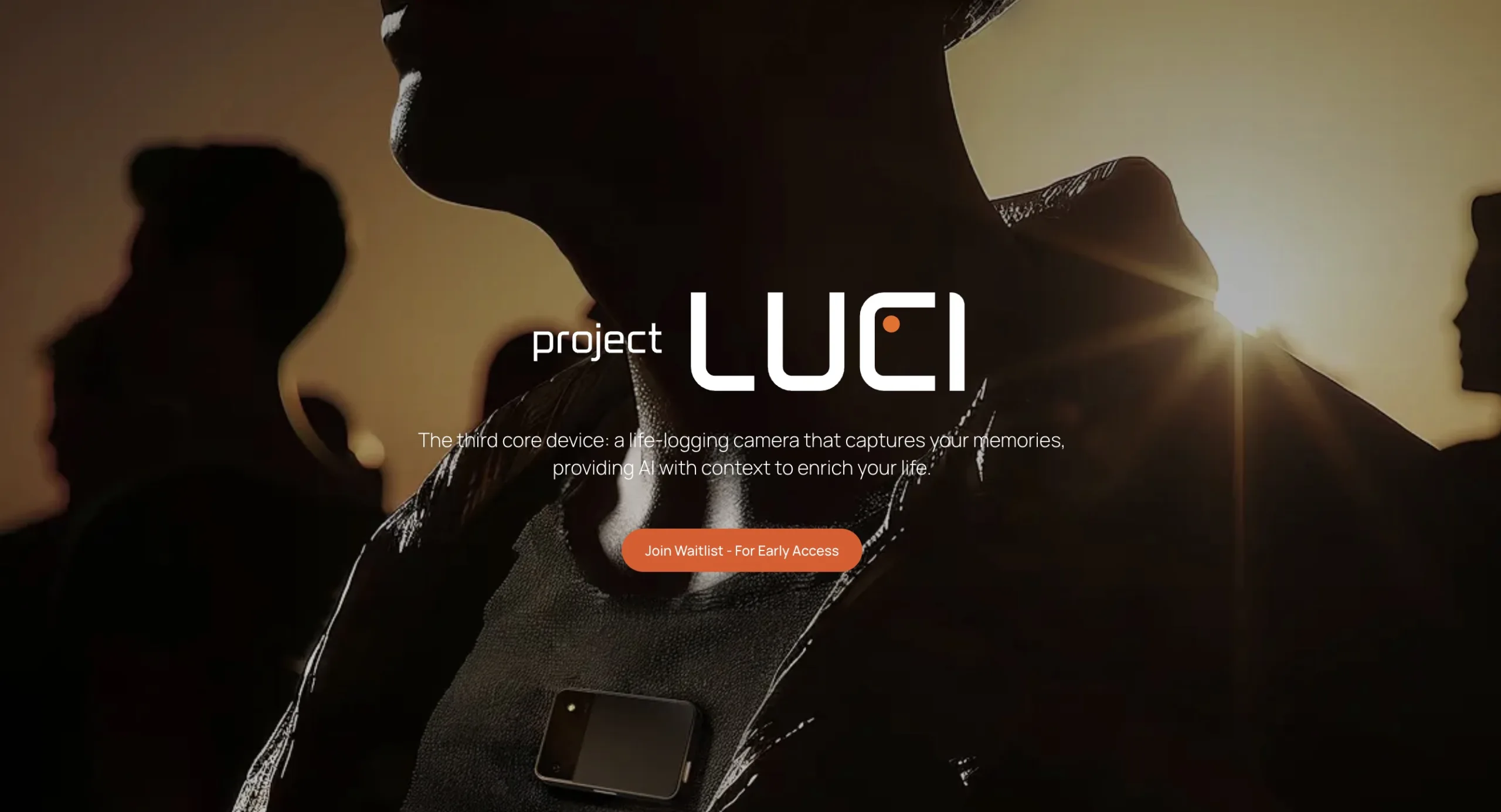

Cara kerjanya cukup kompleks. Kamera wearable merekam data visual berbasis video, kemudian perangkat melakukan pemrosesan langsung di dalam chip (on-device processing). Hasil pengolahan ini disimpan dalam bentuk memori visual, yang bisa dipanggil kembali oleh pengguna melalui perintah sederhana.

Misalnya, pengguna dapat menanyakan,

“Apa yang saya bicarakan saat rapat kemarin?”

LUCI akan menampilkan kembali cuplikan konteks atau percakapan yang relevan, lengkap dengan transkrip yang bisa ditelusuri.

Konsep ini merupakan lompatan besar dibandingkan AI wearable sebelumnya, yang hanya mampu merespons perintah tanpa pemahaman historis. Dengan LVMM 2.0, AI tidak lagi menjadi alat instan, melainkan asisten pribadi yang mengerti kebiasaan, keputusan, dan situasi penggunanya.

Belajar dari Kegagalan Humane AI Pin dan Rabbit R1

Shawn Shen, Co-Founder sekaligus CEO Memories.ai, menegaskan bahwa Project LUCI lahir dari analisis terhadap kegagalan sejumlah produk AI wearable terdahulu.

Produk seperti Humane AI Pin dan Rabbit R1 sempat mencuri perhatian publik karena menjanjikan interaksi AI yang alami. Namun kenyataannya, performa di lapangan tidak memenuhi ekspektasi. Masalah seperti respon yang lambat, ketergantungan tinggi pada cloud, serta kesulitan mengeksekusi perintah sederhana seperti memesan transportasi menjadi hambatan utama.

Menurut Shen, akar masalahnya bukan pada ide, tetapi ketiadaan memori kontekstual yang berkelanjutan. Tanpa kemampuan untuk mengingat dan memahami situasi pengguna, AI wearable tidak bisa benar-benar membantu dalam aktivitas nyata.

Respon (2)